Milyen hardver szükséges a Large Language Modellek (LLM) lokális futtatásához?

Gyors ugrás: Processzor (CPU) – Videokártya (GPU) – Memória (RAM) – Tároló (SSD meghajtók)

LocalAI. Az AI nagy nyelvi modellek (LLM-ek) az utóbbi hónapokban/években szinte felfoghatatlan ütemben fejlődtek és fejlődnek, folyamatosan újabb és jobb, egyre hatékonyabb modellek jelennek meg. Az NVIDIA, az Intel, az AMD és más hardvergyártók folyamatosan fejlesztik az ilyen modellek működtetésére fókuszáló hardvereket. Az előző blogbejegyzésben kiveséztük, mikor lehet szükség lokálisan futtatott AI-ra. Az, hogy mi a „legjobb” hardver egy kiválasztott LLM lokális üzemeltetéséhez, az a feladattól függően erősen változik, de azért van néhány általános iránymutatás, amelyet megadhatunk. Az alábbi kérdezz-felelek, a CtrlAI Labs csapatunk tagjai által adott válaszokkal lefedi az alapokat. Kérjük, forduljon szakértő tanácsadóinkhoz, ha segítségre van szüksége saját LLM-kiszolgálójának konfigurálásához és/vagy megépítéséhez.

Processzor (CPU)

A nagy nyelvi modellszerverek esetében a konkrét CPU általában nem annyira fontos, mint a platform, amelyre telepítik. Az LLM-ek és az azokat használó alkalmazások hosztingjához erősen ajánljuk a szerver szintű platformokat, mint például az Intel Xeon vagy az AMD EPYC. Ezek a platformok olyan kulcsfontosságú jellemzőkkel rendelkeznek, mint a sok PCI-Express sáv a GPU-k, az NVMe SSD-k és a hálókártyák számára, a nagy memória-sávszélesség/kapacitás és az ECC hibajavító memóriatámogatás. A kisebb LLM modelekhez persze a nem-szerver szintű platformok, vagyis desktop processzorok is elegendőek lehetnek, mint az Intel Core-i7, Core-i9, illetve az AMD Ryzen 7 és 9 sorozat.

Melyik CPU a legjobb a nagy nyelvi modellek (LLM-ek) futtatásához?

A két leginkább ajánlott professzionális CPU platform az Intel Xeon W (workstation) sorozata és az AMD’s Threadripper PRO. Mindkettő nagy magszámot, kiváló memóriateljesítményt, kapacitást és nagyszámú PCIe-sávot kínál. Konkrétan bármelyik CPU 32-magos változata ajánlott a kihasználtság és a kiegyensúlyozott memóriateljesítmény miatt.

A magasabb CPU-magszám gyorsabbá teszi a nagy nyelvi modelleket?

Hacsak nem CPU-n futtat LLM-et – ami általában nem ajánlott – a CPU-magok számának alig van hatása azon túl, hogy a rendszerben GPU-nként legalább egy magra van szükség. Valójában azért jobb megközelítés, hogy GPU-nként minimum 2-mag / 4-szál legyen.

Ha azonban a munkafolyamat nem csak a generatív modellek futtatását foglalja magában, a CPU-nak nagy hatása lehet. Ha például a munkafolyamat egy része adatgyűjtést, manipulációt és elő- vagy utófeldolgozást foglal magában, a CPU kritikus összetevője lehet a munkafolyamatnak.

Az adatvezérlést, beleértve az adatbevitelt, az előfeldolgozást, a kezdeti elemzést, a beágyazások létrehozását és a vektortárolást, a CPU-n kell futtatni, így ezek nem terhelik a GPU-t. Ebben az esetben a CPU jelentős és fontos összetevője lehet az alkalmazási láncnak.

A nagy nyelvi modellek Intel vagy AMD CPU-kkal működnek jobban?

A legtöbbször nem számít, hogy AMD vagy Intel CPU-kat használnak-e, amíg az általános platform kiváló minőségű és szerver szintű. Ám tapasztalataink alapján a nem-szerver szintű konfigurációkban az AMD Ryzen processzorok (pl. AMD Ryzen 9 7900X, AMD Ryzen 9 7950X és AMD Ryzen 9 9950X) jobban teljesítenek, jobb ár/érték viszonyt produkálnak, mint az Intel Core-i7 és Core-i9-esek.

Videokártya (GPU)

GPU is KING! A legfontosabb láncszem, az LLM-eket használó alkalmazások teljes mértékben a GPU-knak köszönhetően váltak igazán használhatóvá, rendkívüli teljesítményt nyújtanak az ilyen típusú számítási megoldásokhoz.

Milyen típusú GPU (videokártya) kell a nagyméretű nyelvi modellekhez?

A LLM szerver alkalmazásokhoz „Professional” vagy „Compute” szintű GPU-kat ajánlunk. Ez azért van így, mert nagyobb mennyiségű VRAM áll rendelkezésre, és mert jobban alkalmazkodnak a szerverház hűtési környezetéhez.

NVIDIA Ada Lovelace GPU kártyák:

- RTX 6000 Ada Gen (48 GB)

- RTX 5000 Ada Gen (32 GB)

- RTX 4500 Ada Gen (24 GB)

- RTX 4000 Ada Gen (20 GB)

NVIDIA DataCenter GPU-k:

- L40 (48 GB)

- L40S (48 GB)

- A40 (48 GB)

- A100 PCIe (80 GB)

illetve akár az AMD Radeon Instinct PCIe GPU-k.

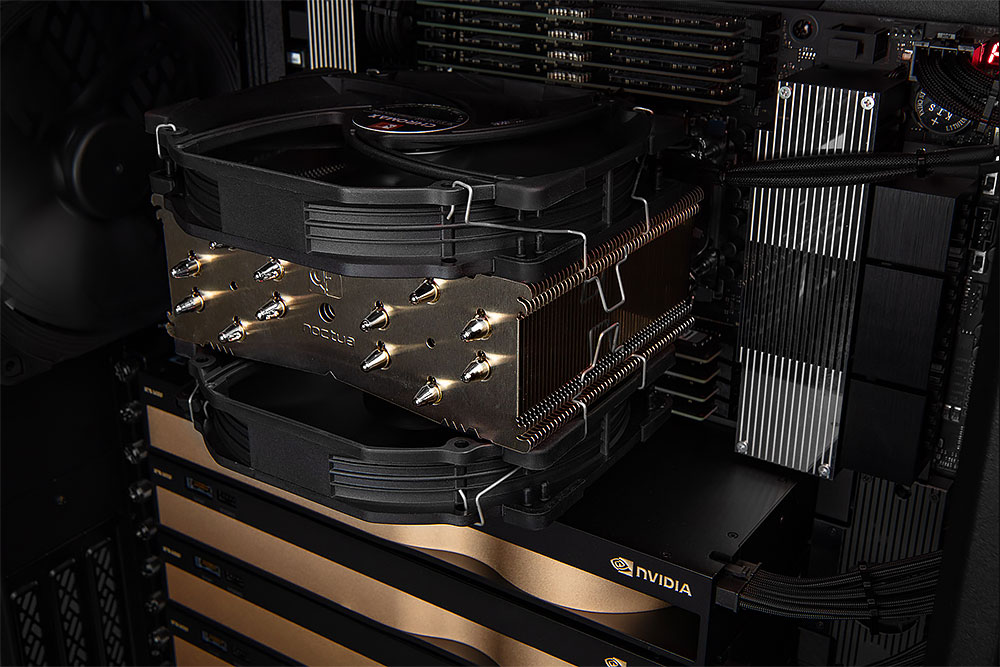

A kisebb paraméterű LLM-ek viszont remekül futtathatók gamer VGA kártyákon is, egy- vagy két darab RTX 3080/3090, vagy még inkább RTX 4080/4090 videokártyán. Két hátránya van a gamer kártyáknak lokális AI használatra: sokkal nagyobb Wattot vesznek fel és elég komolyan tudnak melegedni, nehezebb megoldani a hatékony hűtést.

Mennyi VRAM (video memória) kell a nagy nyelvi modelleknek?

Az LLM-ekkel való munka során a rendelkezésre álló VRAM teljes mennyisége gyakran a legfőbb korlátozó tényező a megvalósíthatóság szempontjából. Az enterprise szintű telepítések esetében az olyan GPU-k, mint a NVIDIA H200 és H100 páratlan teljesítményt nyújtanak, hatalmas CUDA és Tensor magszámmal, nagy VRAM-mal és rendkívüli memória-sávszélességgel, így ideálisak a legnagyobb modellek (Pl. Llama3 405B) és a legintenzívebb AI-munkaterhelések számára. Ám nincs szüksége mindenkinek arra, hogy a legnagyobb modelleket futtassa a munkájához. Például a Llama 70B paraméteres modell natív, 16 bites (FP16) pontosságú futtatásához körülbelül 80-140 GB VRAM szükséges. A Llama3-70b például jó teljesítménnyel kiszolgálható többfelhasználós környezetben (kis/közepes méretű szervezet) 2x 6000 Ada 48 GB vagy L40s GPU-val. De alacsonyabb kvantálás (precizitás) beállítása mellett kevesebb, vagy kisebb GPU-k (2x RTX 5000 Ada 32 GB, vagy akár 2x RTX 4500 Ada 24 GB) is elegendők lehetnek.

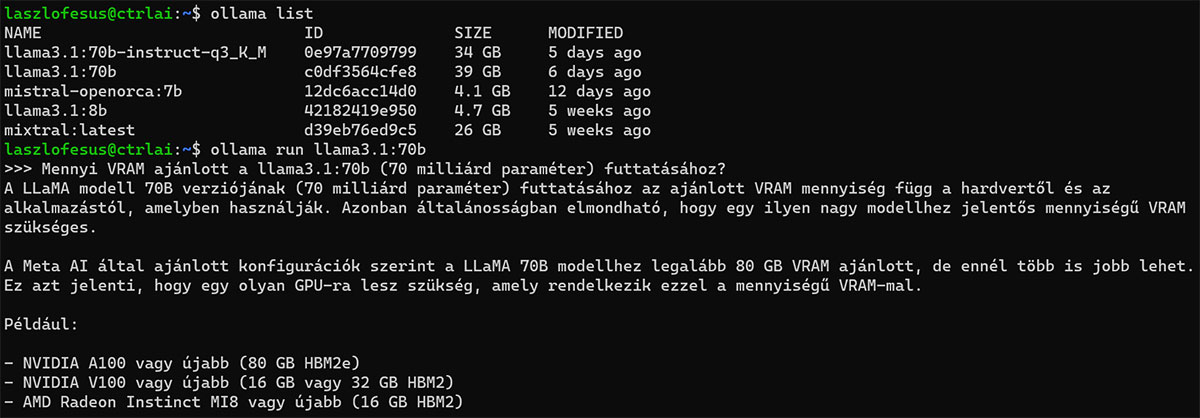

A saját homelab Szerver.Hu CLocalAI Workstation-on megkérdeztem a lokálisan futtatott Llama3.1:70b LLM-et, hogy ő mennyi VRAM-ot javasolna saját magának? Elárulom, ő azért kevesebbet kap, csak 48GB-ot. És köszöni, jól van, szépen fut.

Több GPU javítja az LLM szerverek teljesítményét?

Egyértelműen igen! Az LLM szerverek és keretrendszerek szuperül kihasználják a több GPU-t. Egy Linux-alapú szerver 2-4 GPU-val valójában a „standard” AI rendszer amiket építünk.

A nagy nyelvi modellek jobban futnak NVIDIA vagy AMD GPU-kon?

Az NVIDIA a GPU-számítástechnika történelmi vezetője, és nagymértékben élharcos a mesterséges intelligencia gyors fejlődésében. Továbbra is folytatják az innovációt és generációról generációra jelentős fejlesztéseket hoznak létre a tervezésükben. Az AMD azonban nagyot lépett előre az elmúlt évben. Az AMD ROCm alternatíváját az NVIDIA CUDA mellett aktívan támogatja a Hugging Face és a PyTorch is.

A nagy nyelvi modellekhez „profi” videokártya szükséges?

Technikailag nem, de sokkal nagyobb mennyiségű VRAM-ot kínálnak kártyánként, így komoly LLM szerverekhez szinte mindig ezek a megfelelő választás. Ráadásul a desktop kategóriájú videokártyák általában 3-szlot szélesek, több helyet foglalnak el, kevesebb fér el fizikailag egy szerverben. Mindamellett hűtőrendszerük sem alkalmas rackbe szerelhető házakban való használatra.

És mi újság az AI képgenerálással?

A legnépszerűbb AI- és ML-alkalmazások jelenleg a képgenerálás és -manipuláció körül forognak. Az ilyen típusú hálózatok képzése nagy adathalmazokat igényel, amelyek a képzés során a VRAM-ba íródnak. Könnyebb alkalmazásokhoz kezdetben 12 GB is elegendő, de a komolyabb munkafolyamatokhoz 24 GB VRAM-mal rendelkező RTX 4090-re lesz szükség.

Szükségem van-e NVLinkre, ha több GPU-t használok nagy nyelvi modellekhez?

A legtöbb NVIDIA grafikus kártya már nem támogatja az NVLinket, de vannak olyan kiválasztott GPU-k, amelyek igen, például az NVIDIA H100 NVL. A támogatott GPU-k esetében érdemes az NVLinket használni, de ez nem követelmény az LLM hosztinghoz.

Memória (RAM)

Mennyi rendszermemória szükséges a nagyméretű nyelvi modellekhez?

A NVIDIA (és mi is) legalább kétszer annyi CPU rendszermemóriát javaslunk, mint amennyi a teljes GPU VRAM. Ez lehetővé teszi a teljes „memóriatapasztást” a CPU területére a hatékony pufferelés megkönnyítése érdekében. Tehát egy belépő szintű AI munkaállomás minimum 32 GB RAM, de inkább 64GB vagy 128GB, illetve még több DDR5 RAM javasolt.

Tárolás (SSD-k)

Milyen tárolási konfiguráció működik a legjobban a nagy nyelvi modellek esetén?

Az LLM-eknek otthont adó rendszerekhez nagy kapacitású (2-8 TB) NVMe PCIe SSD meghajtókat ajánlunk. A modellparaméterek és az adatkészletek nagy mennyiségű tárolóhelyet foglalhatnak el, és sok szervernek nagy adatbázisokat is kell fogadnia az alkalmazások használatához. Ehhez a tároláshoz további NVMe SSD-ket lehet használni, szoftveresen vezérelt tömbökben, ha helyi adatredundanciára van szükség.

Kell-e NAS-t használnom nagyméretű nyelvi modellekhez?

Az LLM paramétereket és adatokat a legjobb teljesítmény érdekében helyben, a szerveren SSD-ken kell tárolni, de a hálózathoz csatolt tároló (NAS) életképes lehetőség lehet a biztonsági mentéshez vagy az adatok több rendszer közötti megosztásához.

LLM-szervert keres?

Az Ön munkafolyamataira szabott AI szervereket és munkaállomsokat építünk akár előtelepített Linux/AI/LLM környezettel.

Nem tudja, hol kezdje? Mi segítünk!

Lépjen kapcsolatba még ma AI műszaki tanácsadóink egyikével. Segítünk kiválasztani az adott feladara legalkalmasabb LLM modellt és a hardvert.