Futtasd helyben a legújabb gpt-oss modelleket!

Az Ollama partnerségre lépett az OpenAI-jal, hogy elhozza a legújabb, nyílt súlyú, fejlett gpt-oss modelleket a felhasználók számára. A két új modell, a gpt-oss:20b és a gpt-oss:120b új szintre emeli a helyi futtatású AI-élményt, különösen az ügynök-alapú feladatok, összetett érvelések és fejlesztői felhasználási esetek terén.

Letölthető és helyben futtatható LocalAI-on

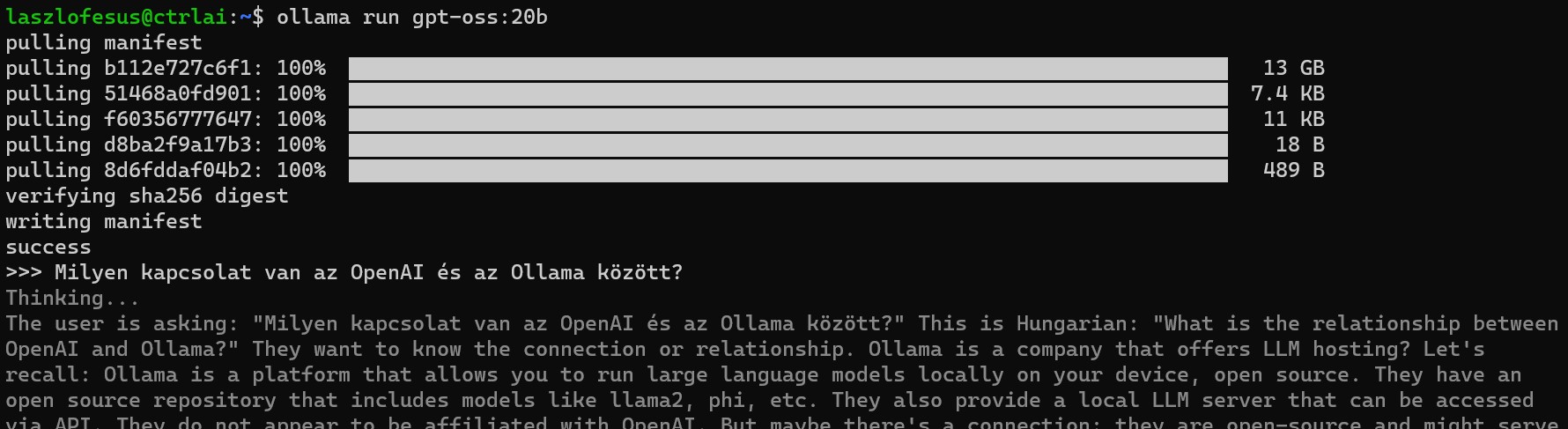

A modellek gond nélkül ingyenesen letölthetők és futtathatók LocalAI munkaállomáson is. Mi, a szerver.Hu LocalAI csapata már aktívan teszteljük őket, eddig alapvetően pozitív tapasztalatokkal. Azért vannak olyan területek, ahol további fejlődés várható, pl. a magyar értelmezés és válaszok még nem állnak az angol szintjén. Mindenesetre teljesen offline, helyi környezetben is könnyedén használhatók, legyen szó fejlesztésről vagy éles munkáról.

gpt-oss:20b

Alacsony késleltetésre, helyi vagy speciális felhasználásra tervezve. Minimum 16 GB egyesített memória vagy GPU memória szükséges a futtatásához. Tökéletes GPU gyorsítás lehet hozzá pl. a PNY GPU nVIDIA RTX 4000 Ada Generation 20GB DDR6 kártya.

gpt-oss:120b

Általános célú, nagy teljesítményű, éles (vállalati) felhasználásra tervezett modell. Minimum 80 GB egyesített memória vagy GPU memória szükséges a futtatásához. Kiemelkedően jól fut pl. egy Nvidia RTX PRO 6000 96GB-os GPU-n.

Főbb jellemzők

- Ügynöki képességek: Funkcióhívás, webes keresés (opcionálisan bekapcsolható), Python-eszköz használat és strukturált kimenetek.

- Teljes gondolatmenet követés: A modell érvelési folyamata teljes egészében hozzáférhető, ami megkönnyíti a hibakeresést és növeli a bizalmat a válaszokban.

- Konfigurálható érvelési szint: Könnyen beállítható alacsony, közepes vagy magas szintű érvelés az adott felhasználási esethez és késleltetési igényekhez igazítva.

- Finomhangolható: Teljesen testreszabható paraméter finomhangolással.

- Szabad felhasználás: Apache 2.0 licenc alatt – nincs copyleft vagy szabadalomhoz kötött korlátozás, ideális kísérletezésre, testreszabásra és kereskedelmi célú használatra.

Nyílt formátum és kompatibilitás

Az Ollama együttműködött az OpenAI-jal annak érdekében, hogy a modellek teljes mértékben kompatibilisek legyenek az OpenAI hivatalos megvalósításával. A modellek az MXFP4 alapértelmezett formátumot használják, további kvantálás vagy konverzió nélkül.

Webes keresés támogatás

A gpt-oss modellek képesek eszközök, például webes keresés használatára is. Az Ollama új alkalmazásában már beépített, opcionálisan engedélyezhető webkeresés érhető el, amely friss információkkal egészíti ki a modell tudását.

A funkció használatához Ollama-fiók szükséges. Az Ollama nem naplózza és nem őrzi meg a keresési adatokat. Szükség esetén a rendszer a Google keresést használhatja háttérként. A teljesen offline élményhez az alkalmazásban elérhető az „airplane mode” beállítás.

Turbo mód

Az Ollama jelenleg előnézetben kínálja új „Turbo módját”. Ez a szolgáltatás lehetővé teszi, hogy az extra nagy modellek is gyorsan fussonak, datacenter-szintű hardvereken keresztül – akár az alkalmazásból, CLI-ből vagy API-n keresztül is.

Ez egy opcionális szolgáltatás, nem érinti a teljesen helyi használatot.

NVIDIA + Ollama együttműködés

Az NVIDIA és az Ollama együttműködnek, hogy gyorsabbá és hatékonyabbá tegyék a gpt-oss modellek futtatását GeForce RTX és RTX PRO GPU-kon. Az együttműködés célja, hogy az RTX-alapú számítógépek felhasználói a lehető legtöbbet hozzák ki a gpt-oss modellekből.

A jövőben részletes mérnöki blogposzt is várható a modellekről.

Hogyan kezdj hozzá?

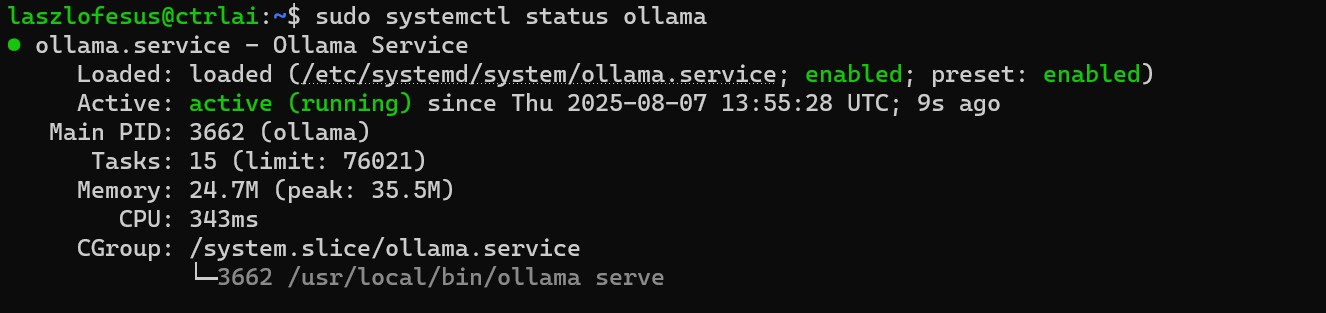

A modellek egyszerűen letölthetők és futtathatók az Ollama új alkalmazásából vagy a parancssoros felületen keresztül:

ollama run gpt-oss:20b

ollama run gpt-oss:120b

A legfrissebb Ollama verzió: 0.11