Miért igényelnek nagy nyelvi modellek sok RAM-ot?

A nagy nyelvi modellek (LLM-ek), mint például a GPT-4 és az LLaMA 3, hihetetlenül nagy teljesítményűek, de memóriát illetően rendkívül igényesek. Hogy ezt szemléltessük: egy közepes méretű modell, mint az LLaMA 3 (kb. 70 milliárd paraméterrel) futtatásához általában legalább 140 GB RAM szükséges standard pontosság mellett.

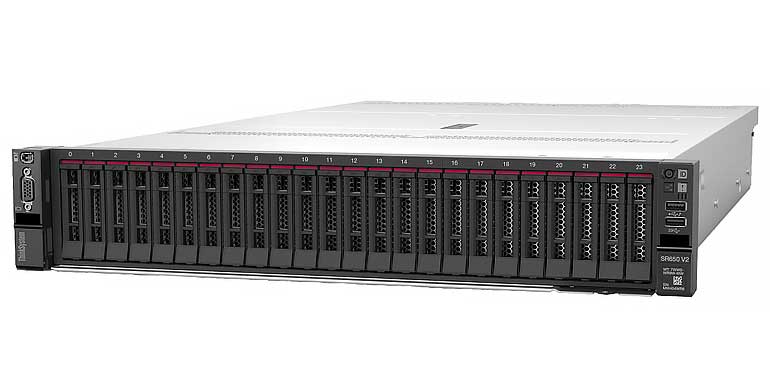

Az óriási LLaMA 3 405B elméletileg csaknem egy terabájt memóriát igényelne hagyományos konfigurációban, ami PC-konfigurációval már nem megoldható, mindenképpen duplaprocesszoros szerver konfig kell hozzá.

Az ok egyszerű: ezeknek a modelleknek milliárdnyi (igen, milliárdnyi!) numerikus súlyt kell tárolniuk a memóriában, hogy gyors számításokat tudjanak végrehajtani és koherens eredményeket generálni. Ha ezekhez a súlyokhoz nem lehet elég gyorsan hozzáférni, az egész modell lelassul, és ezzel elveszíti lenyűgöző számítási képességeinek értelmét.

Moduláris vagy egységes: mi a lényeg?

Hagyományosan a PC-k külön RAM-modulokkal rendelkeznek, amelyek az alaplapba illeszkednek. Ez rugalmas és könnyen frissíthető, de van egy hátránya: az adatoknak folyamatosan oda-vissza kell vándorolniuk a moduláris RAM-modulok és a processzorok között. Ez késleltetést és sávszélesség-szűkületeket okoz, ami különösen káros az AI-feladatok esetében.

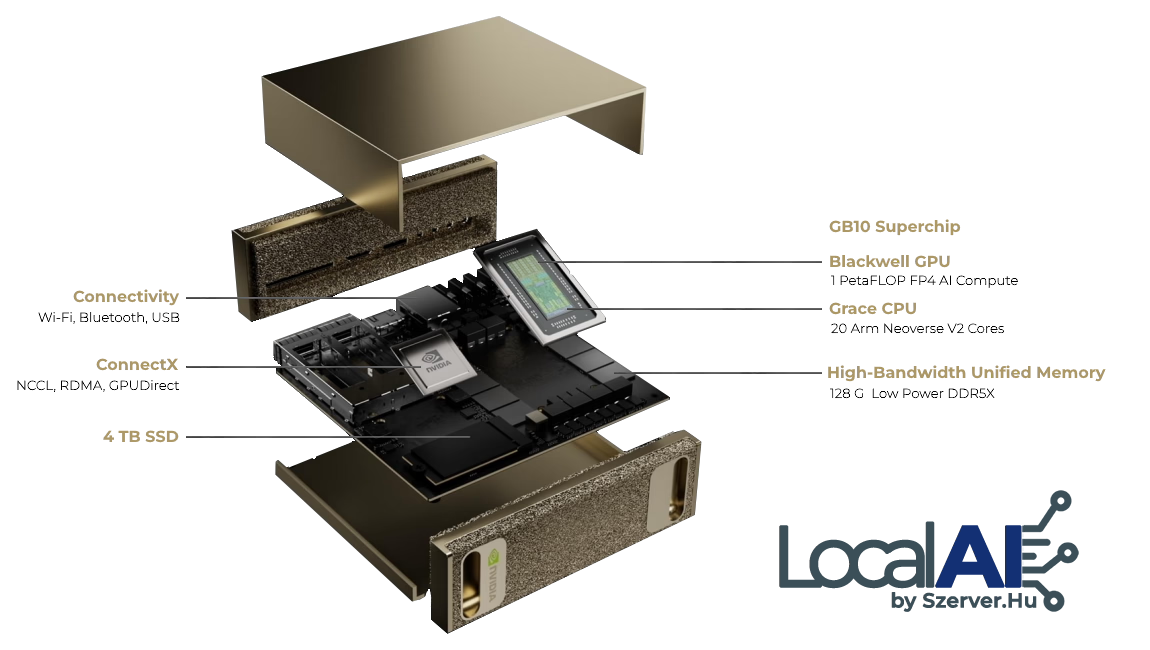

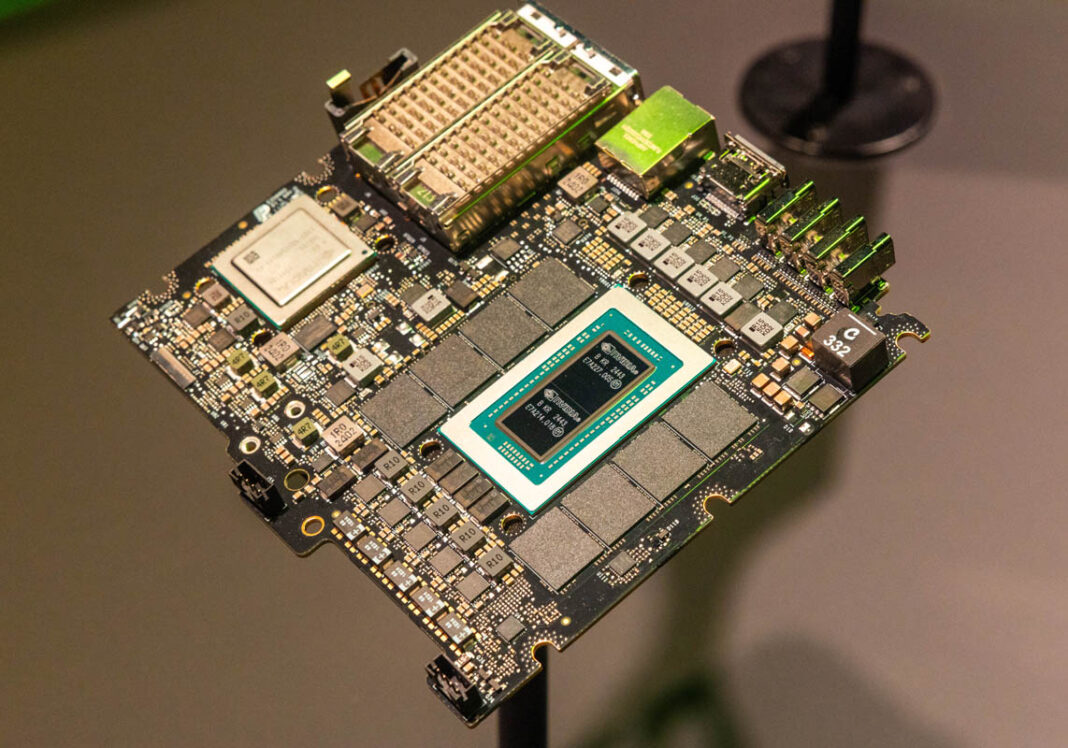

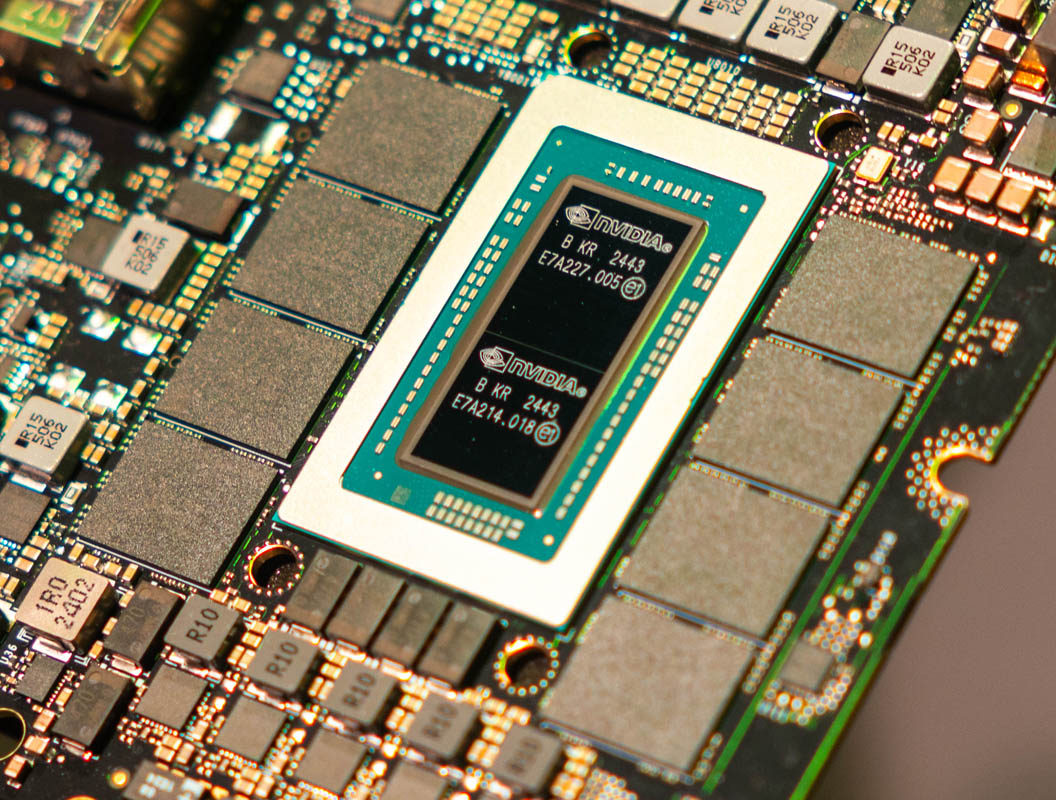

Az egységes RAM megoldja ezt a problémát. Képzelje el, hogy a processzort és a RAM-ot nem távoli városokban, hanem ugyanabban az épületben helyezik el egymás szomszédságában. A RAM közvetlenül a CPU-k és GPU-k mellé integrálásával az egységes RAM-rendszerek – mint például az NVIDIA DGX Spark és az Apple M-sorozatú chipjei – jelentősen gyorsabb hozzáférést biztosítanak, csökkentve a késleltetést és jelentősen növelve a sávszélességet.

Az Apple egységes megközelítése: előzetes bemutató a fogyasztóknak

Az Apple csendben mutatta be ezt a forradalmat M-sorozatú chipjeivel (M1, M2, M3). Ezek a chipek a CPU-t, a GPU-t és a memóriát egyetlen csomagban integrálják, lehetővé téve az adatok szabad és azonnali mozgását. Ezért érződik meglepően gyorsnak és érzékenynek a MacBookok ezekkel a chipekkel, még akkor is, ha kevesebb RAM-mal rendelkeznek, mint a hagyományos számítógépek.

Az Apple M-sorozata lényegében bepillantást enged a mindennapi felhasználóknak az AI-számítások jövőjébe, ahol a hardvert olyan mértékben optimalizálták a memóriahatékonyság és a sebesség érdekében, hogy a hagyományos, különálló, frissíthető alkatrészek koncepciója kezd elhalványulni.

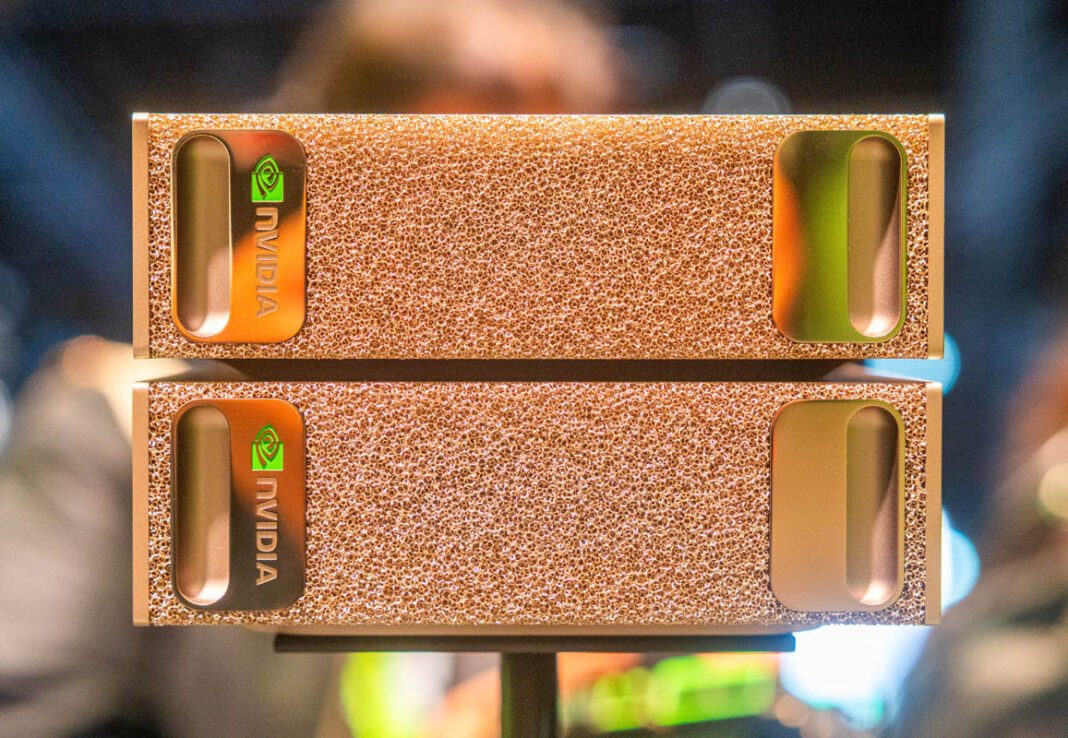

DGX Spark: az NVIDIA elképzelése az AI-számításról

A DGX Sparkkal az NVIDIA nem csak a technológiai rajongókat célozza meg, hanem megteremti a személyes AI-szuperszámítógépek alapjait. A Grace CPU, a Blackwell GPU és a 128 GB egységes memória integrálásával egy kompakt, elegáns eszközbe egyértelmű útitervet vázolnak fel a számítástechnika következő évtizedére.

De miért állt meg 128 GB-nál? Nem tudott volna az NVIDIA több memóriát beépíteni? Technikailag igen, de a további egységes RAM integrálása nem csupán extra chipek forrasztását jelenti. Gondos hőkezelést, óvatos áramelosztást és fejlett gyártást igényel, és minden egyes lépés exponenciálisan növeli a komplexitást és a költségeket. Ezért az olyan eszközök, mint a DGX Spark, gondosan egyensúlyoznak az ár, a teljesítmény és a praktikum között.

Filozófiai és gyakorlati következmények

Ahogy a számítástechnika az egységes architektúrák felé halad, néhány nehéz kérdéssel kell szembenéznünk:

- Javíthatóság és frissítések: Az egységes memória hatékony, de feláldozza a modularitást. Elfogadjuk-e azokat az eszközöket, amelyeket nem lehet könnyen frissíteni vagy javítani?

- Monopóliumok és piaci ellenőrzés: Mivel egyre kevesebb vállalat képes ilyen komplex integrált chipeket tervezni, elfogadjuk-e, hogy néhány technológiai óriás uralja a számítástechnikai infrastruktúránkat?

Ezek nem hipotetikus kérdések, hanem sürgető problémák, mivel egy olyan korszakba lépünk, ahol a szilíciumtervezés és a félvezetőgyártás uralkodik, és a hagyományos számítástechnikai megközelítések háttérbe szorulnak.

A jövő egységes

A DGX Spark több mint egy eszköz, egy útjelző. A kompakt, egységes memóriaarchitektúrák felé való átállást jelzi, amelyeket kifejezetten intenzív AI-terhelésekhez terveztek. Ez a változás nem ideiglenes, hanem a számítástechnika alapvető fejlődésének része.

Ahogy ezen az úton haladunk, a hardverrel kapcsolatos döntéseink nem csupán a készülékeink teljesítményét befolyásolják, hanem az elkövetkező évtizedek technológiai innovációjának, hozzáférhetőségének és energiaelosztásának jellegét is meghatározzák.

Mit gondolsz, készen állunk-e erre az egységes jövőre, vagy többet kockáztatunk, mint amennyit nyerhetünk?